Contents

はじめに

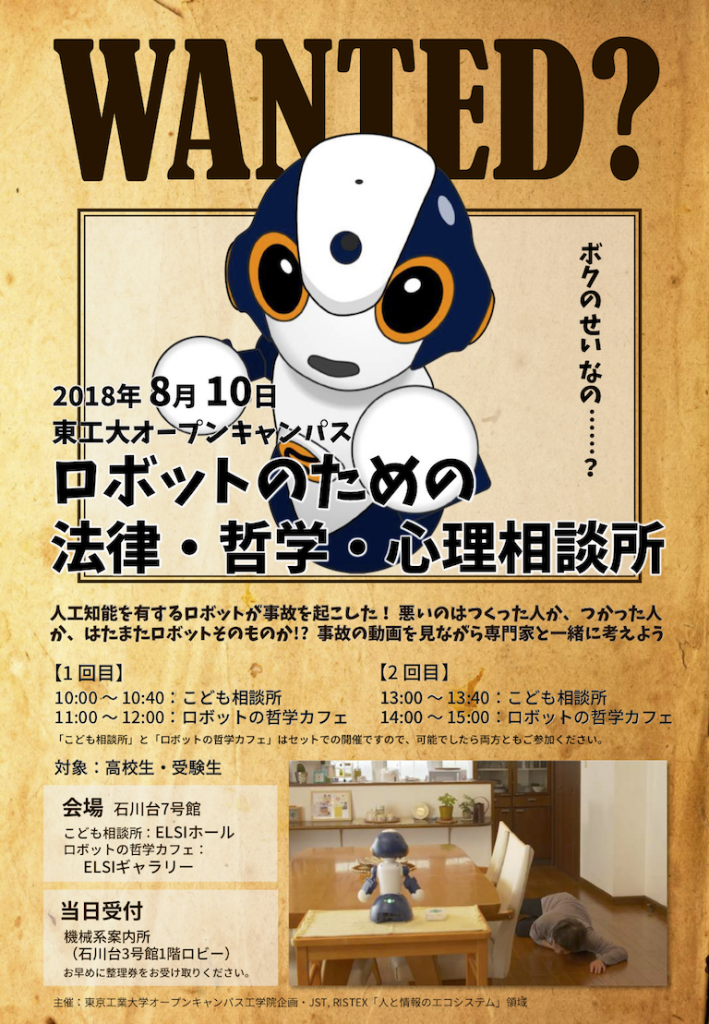

近年、学習型人工知能をはじめとする、高度に自律的な人工システムを搭載したロボットが開発されつつあります。そのようなロボットが事故や事件の原因になったとき、その責任は誰かにあるのでしょうか。この責任の問題に対して、本プロジェクトでは、工学・心理学・哲学・法学の研究者らが共同で研究を進めています。さらに、この問題を扱う上で、研究者以外の方の多様なご意見や視点を取り入れることが不可欠であると考えています。そこで、2018年8月10日に高校生向けのワークショップ「ロボットのための法律・哲学・心理相談所」を東京工業大学で開催し、2018年8月21日と10月14日に一般公開ワークショップ「一緒にさがそう未来のルール 〜ロボットの事故は誰かのせい?」を日本科学未来館で開催しまして、合計125名以上にご参加いただきました。

これらのワークショップでは、ロボットが事故を起こす架空の事例ビデオを参加者らが視聴し、事故の関係者に対する責任を参加者らがそれぞれ考えます。その後、工学・心理学・哲学・法学の四領域の研究者がそれぞれの立場でコメントし、参加者らと共に議論します。この対話を通して、将来の高度な人工システムと人間の共生社会にあるべき法や倫理を共に探りたいと考えています。

これらのワークショップでは、ロボットが事故を起こす架空の事例ビデオを参加者らが視聴し、事故の関係者に対する責任を参加者らがそれぞれ考えます。その後、工学・心理学・哲学・法学の四領域の研究者がそれぞれの立場でコメントし、参加者らと共に議論します。この対話を通して、将来の高度な人工システムと人間の共生社会にあるべき法や倫理を共に探りたいと考えています。

このページでは、そのワークショップで用いた事例ビデオを公開し、その責任に関する来場者のご意見の一部を掲載することで、責任問題に関する様々な考えを紹介します。さらに、そのワークショップでの研究者らの講演の概要と、それらに関する来場者からのご質問と研究者の回答の一部を掲載します。なお、東京工業大学でのワークショップの様子はJST RISTEXのウェブサイトでもご覧いただけます。

事例映像

誰かのせい? 〜来場者のご意見

Aさんに責任があると思う理由

- Aさんは優先順位(薬かセキュリティか)をロボットに明確に伝えていないから。

- ロボットがどんな対応をするのか、Aさんはしっかり理解できていないから。

- Aさんはロボットを信用しすぎているから。

- 人が自己の判断と責任で機械を扱うべきだから。

Aさんに責任がないと思う理由

- Aさんのロボットの使い方には問題がないから。

- Aさんはロボットに「知らない人が来たら鍵を開けないように」と指示していたから。

- ユーザーに責任を求めるのは酷だから。

メーカーに責任があると思う理由

- ロボットのプログラムを作ったのはメーカーだから。

- ホームセキュリティロボットとして社会に出すまでのレベルに達していないから。

- メーカーはどんなことが起きてもよいように予想すべきだから。

メーカーに責任がないと思う理由

- ロボットはAさんの指示通りに正当な判断をしたから。

- 完璧な技術はあり得ないので、メーカーに100%の罪があると考えるのは非合理的だから。

ロボットに責任があると思う理由

- ロボットがAさんの指示に反して鍵を開けたから。

- ロボットが事故の原因の張本人だから。

ロボットに責任がないと思う理由

- ロボットはプログラム通り人命を優先しただけだから。

- もしロボットが人であったら、人道的な判断だったと思うから。

- ロボットに責任能力はないから。

来場者のご意見

- 法律の整備が必要であると感じました。AIもロボットもプログラマーの考え方とプログラミングの技術にすべてゆだねることはできないので、ある程度オープンソースにする必要もあると思いました。

- 現実にこういうことも起こりえそうである。ロボットに依存してゆく人間は増加するだろう。少子高齢化時代にこのロボットは多いに売れるだろう。そうして、このロボットをだます人間も出てくるだろう。ロボットを作るメーカーは、様々な事を想定し、出来ることも、法的にどうかといった視点で判断しながら、ロボットを作っているのだろうと思う。そうすると、人間に近いロボットはやはり完成しないのではないか。技術的にできたとしてもメーカーは作りたくないという気がしてきた。

- IoTについては信用しておらず、今の進歩ついて、情報の漏洩や制御不可能性など、開発者が予想しえない事態が起こるのではないかと今しばらくは様子見をしたい。

- メーカーがトラブルをどこまで責任もって補償し、メカニズムを改善していくか、まずその制度に不信感が存在する。それは工学・ロボット科学以前の問題だと思う。

- 科学分野の発展はとても必要で大事なことだと思うが、全ての分野でロボット(感情や知能を持った)が肩代わりできるとは思わない。難しい題材だと思う。自動運転の車が事故を起こした場合、その責任は誰が取るのでしょうか。車製造のメーカー、運転を任せっぱなしにした運転者。まだまだ発展途上の現在では、課題が多いと感じる。(ただ、ドラえもんがいたら,やさしい社会になれるだろうなあ)

- 生活を豊かにする一方、使用者が正しく使わなければ事故は起きてしまう。あくまでもロボットやAIはツールであると思います。

- ロボット(人工知能)も人間と同じ判断ミスをするものだと思うので、通常の製品のようにメーカーと利用者の責任を問うのは難しいと思った。

- ロボットと生活することの難しさを感じました。頼るほど管理や責任の所在が難しくなる。愛玩動物的な関わりの方が気楽なような。高齢化により一人暮らしの老人が増える一方、生活を助けてくれるロボットに頼りたい。色々な感情が湧いてきました。

- 今回のビデオではAさんがしっかりとしている方なのでロボットをうまく使える場面が多かったが、認知症や誤学習をしてしまうこともあるので、ここまでの実用化は怖いし、難しいだろうと思う。ロボットが生活に身近な存在になっていくことは賛成である。

- メーカー、ロボット、ユーザーの責任を明確化するのは困難なので、責任の所在を明確化しなくても「丸く収まる」方法を考えるのが現実的かもしれない。また、責任の明確化を追求しすぎると、技術発展の芽を摘んでしまう可能性があると感じた。

- ロボットを使いこなすのが「人」である。「人」によってそのロボットの可能性と能力をどこまで引き出し運用することができるのか? 教育や体験も含めて、生活が豊かで便利になる最善を考えていく機会と時間が必要だと感じました。

- ロボットが普及した場合、ある一定の確率で事故等は発生してしまうと思うので、そのための補償の制度を整えることは良いことだと思います。また、事故事象をできるだけ公開して、事故への対応力向上を進めるべきだと思います。

- メーカーは考え得るあらゆるリスクを回避するための努力をすべきだと思う。

- 新しい技術はトライ&エラーの積み重ねで進展していくものなので寛容な社会であればと思う。(被害者本人はそうも言っていられないでしょうが……)

- 未来の世界のシステムで失われていく人間という生き物の価値が変わっていってしまうことが良いのかどうかわからなくなってきました。人間自らの行動を機械に委ねる時代になってしまうのか。世界の弱者を置き去りにしてしまうのか。多くの価値観の多様性が失われないか。

- 改めて、三者の側に立って考えてみると、思っていたよりもずっと難しかったです。つくる側、使う側というのも大切ですが、今回新たに、法律や保険等の決まりごとをしっかりと作っておくことが未来を守っていくのだと感じました。この世界での人工知能の立場について、もう少し知りたいと思いました。

- 現実に近未来起こりうる状況を例にした調査のため、自分ごととして取り組むことができました。調査対象が少ないかもしれませんが、こうした声がきちんと行政や研究現場、経済界にフィードバックされることを期待します。大変意義があることと思います。

研究者の講演概要

【工学】人工知能技術の課題と責任

河合 祐司

大阪大学大学院工学研究科・助教

(現在:大阪大学先導的学際研究機構・特任講師)

人工知能・ロボットの責任問題

まず、本企画の趣旨が「人工知能やロボットは危険である」ことを周知することではないことを強調したく思います。複雑な環境や人間と相互作用する人工知能技術によって我々の生活が格段に豊かになることが期待されており、人工知能やロボットの研究者や開発者は、事故が起こらないように、また、それらが人間社会に有益なものとなるように最大限の努力をしています [1]。

しかし、特にその相互作用の中で学習するような自律性の高い人工システムは、設計者の手から離れ、設計者の意図しない振る舞いをする可能性があることを完全には否定できません。そのような人工システムが起こしえる事故を設計者が事前に予見することは、従来の固定的なシステムの場合に比べ困難になります。その万が一の事故の責任がその設計者やメーカーにあるのであれば、そのようなシステムをそもそも開発できません。一方で、その責任がユーザーにあり、使い方が悪かったんだ、ということになると、そのような製品を欲しいと思う人もいなくなるでしょう。とても有益だけど事故の可能性を完全には否定できない人工システムを開発することが許されるかどうかは、この責任の問題にかかっているといえます。

人工知能技術の課題

近年の人工知能技術は深層学習という機械学習手法によってブレークスルーを果たしました。これは多数の非線形変換を繰り返すことで、大量の訓練データからデータ間に内在する統計を学習し、複雑な情報処理を実現する手法です。深層学習によって実環境で動作する有益な技術が開発されている一方で、その技術の課題も議論されています。

まず、そもそも訓練データに偏りがある場合です。例えば、人間の言語を学習した人工知能が、人間が有するものと同様の人種やジェンダーに関する偏見を有することが報告されました [2]。また、巧妙に作られたノイズを入力データに加えることで、深層学習の誤った出力を導けることが発表され、注目を集めています [3]。さらに、内部で複雑な処理を行う深層学習はブラックボックス化しているという指摘もあります。現在、人工知能の内的過程の説明を試みる手法が盛んに研究されていますが、人間ですら自身の意思決定の全てを説明できないのに、その説明が可能であるかは私は疑問に思っています。

人工知能をハーネスする

安心安全なロボットや人工知能に向けて、研究者や開発者は不断の努力をしています。しかし、複雑な環境や人間と関わるロボットや人工知能が、開発者の予期せぬ振る舞いをすることを、少なくとも現在では完全に否定できません。

最近の人工知能の倫理に関する論文 [4] では、人工知能を「ハーネス」するという言葉が使われています。この「ハーネス」という動詞は、馬具を取り付けて乗りこなすという意味を含みます。人が完全にコントロールできる固定的なシステムのみに限定するのではなく、複雑な処理を行う人工知能の良さを生かすように統制し、うまく活用していくという方向もあるのではないかと思います。そのためには、開発者・使用者・社会制度設計者が一体となったルールづくりが必要になります。その実現を目指して、我々の研究チームでは工学者・心理学者・哲学者・法学者がタッグを組んで、さらに、研究者以外の皆様のご意見を取り入れながら、この課題に取り組んでいるところです。

[1] 人工知能学会 倫理指針 序文

[2] A. Caliskan, et al., “Semantics derived automatically from language corpora contain human-like biases,” Science, Vol. 356, No. 6334, pp. 183-186, 2017.

[3] C. Szegedy, et al., “Intriguing properties of neural networks,” in Proc. Int. Conf. Learn. Representations, 2014.

[4] M. Taddeo and L. Floridi, “How AI can be a force for good,” Science, Vol., 361, No. 6404, pp. 751-752, 2018.

【心理学】ヒトの心理:自分で操作したものには責任を感じやすいか

葭田 貴子

東京工業大学工学院機械系・准教授

ウェアラブルロボットの操作主体感

現在、人の身体にロボットを装着し、人の動きのパワーを助けるウェアラブルロボットの研究開発が盛んです。私も実際にウェアラブルロボットを使用してみたところ、自分とロボットが一体化したような心地だった一方で、自分の意図しない動きをロボットがした場合に恐怖を感じたことがありました。通常、自分の身体は自分が操作していますが、このロボットを装着することで、自分の身体を自分だけでなくロボットも操作することになり、その操作主体感が揺らぐ可能性があります。

これはウェアラブルロボットに限った話ではなく、例えば半自動運転(運転支援)システムでも考えられます。米国自動車技術会の定める自動運転のレベルの定義 [1] によると、レベル2までは人が主体となって車を操作しますが、レベル3以降では、徐々に人工知能システムが主体になっていきます。人とシステムが相乗りになって車を運転しているときの操作主体感は、やはり揺らぎえると考えられます。

操作主体感のメカニズム

操作主体感ないし制御主体感とは、自分が操作している主体であって、機械や人工知能を含む他人に操作されているのではないという感覚を指します。その認知メカニズムとしてGallagher [2] のモデルがあります。脳は、対象の意図した状態を達成するための運動指令を筋系に送る一方で、その運動指令のコピーを他の脳領域(順モデル)に送ります。その順モデルでは、その運動指令がもたらすであろう対象の状態が予測されます。その予測された状態と意図した状態が比較され、それらが整合的であればその行為主体が自分であると感じます。

さらに、我々はウェアラブルロボットにおける主体感の脳内メカニズムを探る脳計測実験を行いました [3]。MRIと呼ばれる脳計測装置には金属を入れられないので、金属を用いない人工筋を使って人の手首の運動を駆動させるロボットを用いました。人が能動的に手首を動かすときの脳活動と、手首がロボットによって受動的に動かされるときの脳活動を比較して、身体の操作主体感に関する脳領域を同定しています。

その先にある問題:ユーザーの感じる責任

人の操作主体感が揺らぐことの先に、責任感の問題があります。操作の結果、事件や事故など社会的に思わしくない状況になった場合、人(ユーザー)が操作主体感を有していれば、ユーザーがその責任感を抱きやすいことが考えられます。一方で、操作主体感が低い場合、それが機械や他人に操作されたことであり、強要されたことであると思うことが予想されます。その場合、ユーザーは責任感を抱きにくく、メーカーやシステムそのものに責任転嫁する可能性が考えられます。すなわち、人から機械に主体が移ることで、ユーザーが自分に責任はないと感じやすくなるといえます。

しかし、ここで一つ疑問があります。人はいつも自分の意思や意図で主体的に動いているのでしょうか。この問いは自由意志論争に関連し、心理学や認知科学の研究から、必ずしもそうではないことが示されつつあります。社会的に受容される人工知能・ロボットを開発するには、主体性や責任感など人の心のはたらきを考慮する必要があるでしょう。

[1] https://www.sae.org/standards/content/j3016_201609/

[2] S. Gallagher, “Philosophical conceptions of the self: implications for cognitive science,” Trends in Cognitive Science, Vol. 4, No. 1, pp. 14-21, 2000.

[3] 神谷聖耶ら,『視覚と触覚のマルチモーダルな情報処理と機器の操作性』,技術情報協会編,五感インタフェース技術と製品開発事例集~ヒトの知覚メカニズムと感覚間の相互作用~,技術情報協会,pp. 240-251, 2016.

【哲学】人工知能の何が問題なのか

松浦 和也

東洋大学文学部哲学科・准教授

誰も責任はとりたくない

このような問題を扱うにあたって、最初に確認をしておかなければならないことがあります。それは、自ら望んで責任を取りたがる人間はおそらく誰もいないだろうということです。会場の中に、何に関することであれ、責任を取りたくてたまらない、という方はいらっしゃいますか。そう、人工知能の開発者も、メーカーも、使用者も、もしかしたら人工知能自体も、誰も責任を取りたくはないのです。だから、責任を取らざるを得なくなった時に、せめてその人と社会が納得するような理由付けを与えてやる必要があります。

行為の良し悪し

その際のひとつの指標は、ある事故に関係する人たちの行為や振る舞いの良し悪しにあるでしょう。では、行為や振る舞いの良し悪しはどのように評価されるのでしょうか。一つの見方は、法律やルールに従っているから良い、というものでしょう。一方、必ずしもそうではないことも私たちは経験的に知っています。つまり、好ましい行為/振る舞いだから良く、責められる行為/振る舞いだから悪い、という見方もできます。そのような文化や価値観を整理し、ルール化していくことが、哲学や倫理学の重要な役割になります。たとえば、どのような人が責められるのかということを義務論という立場から考えると、その人が為すべきこと為したかどうかが判断基準になります。例えば、メーカーは製品の説明をユーザーに十分したかどうか、ユーザーは製品の説明を十分に理解したかどうかです。また、別の倫理学的観点である徳倫理学の立場から考えると、その人の性格や傾向性が良かったかどうか、あるいはその人がその製品を扱うのに十分な能力を持っていたか、社会的に正義や公平性を担保しうるものになっているかどうかなどが判断基準になります。

今までの機械と何が違うのか

製品が引き起こした事故について誰が悪いのかを考える際、その事故に至る「開発」、「販売」、「購入」、「利用」の様々な場面で、事故の原因を特定します。そして、その各段階で関係者が法的・社会的義務を果たしていたか、また、どこかに過失がなかったかどうか、そのような事故は想定できる範囲を超えているか、その人がその製品を扱うのに相応しい資格を持っていたか、といった検証がケースバイケースで行われることになります。では、自律的な人工知能を搭載した製品は、従来の製品と何が違うことになるのでしょうか。私は人工知能の相互作用性とブラックボックス化が特に問題になると考えています。ユーザーや環境と相互作用し、また、その内的過程の説明が困難なシステムでは、事故の原因を明確に特定することが非常に難しくなることが予想されます。

機械を悪意から守る

おそらく最大の問題は、誰も事故の理由を説明できないなら、悪意を持った第三者が比較的容易に事故を起こしうることにあります。例えば、開発者が故意にプログラムのバグを仕込んだり、クラッカーがシステムをハッキングしたり、また、悪意あるユーザーがシステムに悪戯をすることも考えられます。人工知能が事故を起こしたときに「誰が責任を取るのか」という問題よりも、「悪意ある人物に責任を取らせることはできるか」がより深刻だと私は考えます。人工知能や開発者、メーカー、使用者を悪意ある第三者から守るための法規制の問題のみならず、悪用を防ぎ、悪用されたときに誰が悪用したのかが分かるような人工知能やロボットのデザインを検討する必要があるでしょう。

【法学】法律は誰のせいにするのか

稲谷 龍彦

京都大学大学院法学研究科・准教授

法的責任とは何か

法律用語で「責任」とは、誰の「せい」で事故が起きたかを表現します。例えば、誰々に「不法行為責任」があるとか、「刑事責任」があるとかという言い方をします。その「責任」の取らせ方には、「過失」と「危険」の二つの考え方があります。

「過失」は民事法と刑事法で基本的に共通します。これは具体的な悪い結果を予見していたにもかかわらず、避けようとしなかったことを「責任」が発生する根拠としています。その背後には、人は自由な意思に基づいて自分の行動を決められるはずだという考え方があります。

一方、「危険」は基本的には民事法における「責任」の取らせ方です。あえて危険物を管理している人は、その事物から生じた悪い結果を引き受けるべきだということを根拠にしています。危険物を管理する人が、その危険を最も容易に管理できるはずだという考え方がその理由であり、結果を予見していなくても「責任」が生じます。この予見の程度で、「過失」と「危険」はグラデーションの関係にあるといえます。

人工知能と「責任」

高度な人工知能は究極的にはブラックボックスになるため、その振る舞いは、設計者も含めて完全には制御不可能であるといえます。そのような人工知能が事故を起こした場合、その製造者や使用者に「責任」が問われるでしょうか。設計者が人工知能の起こす事故を具体的に予見することは難しいですが、人工知能が事故を起こしえること自体は誰でも予見できます。この状況は「過失」と「危険」の間くらいに落ち着いているため、民事でも刑事でも関係者に「責任」が問われえます。

例えば自動運転車による人身事故の場合、民事法では、製造物責任や不法行為責任などが製造者に、さらに、不法行為責任が使用者に問われえます。また、刑事法では、業務上過失致死傷罪が製造者に、自動車運転処罰法関係の罪が使用者に問われえます。

「責任」を避けられるか

このように、製造者にも使用者にも過度な「責任」が問われる可能性があることから、人工知能開発そのものが萎縮してしまうことが懸念されています。そのため、新しい制度が検討されています。民事法に関しては、保険や基金の運用が考えられています。また、刑事法では、訴追裁量の活用が考えられています [1, 2]。例えば、事故原因の究明に製造者が協力し、製品を適切に再設計することで起訴しないことが考えられます。ただし、それぞれに問題が残っているため、最終的には制度全体を時間をかけて構築し直すことが望ましいと私は考えています。そもそも「責任」が生じる原因について、これまでとは違う考え方をする必要があるかもしれません。認知科学や哲学の成果を取り入れて、新たな人間像や倫理に基づく法制度を検討していく必要があると考えています。

[1] 稲谷,『技術の道徳化と刑事法規制』,松尾編著,アーキテクチャと法 〜法学のアーキテクチュアルな転回?,弘文堂,pp. 93-128, 2017.

[2] 稲谷,『人工知能搭載機器に関する新たな刑事法規制について』,法律時報,Vol. 91, No. 4, pp. 54-59, 2019.

来場者からのご質問

人工知能をハーネスするとは、具体的にどのようにするのでしょうか?

(河合)人工知能が稀に事故を起こし得ることを前提とした社会制度を設計することで、社会として人工知能を受容するようになることを期待します。ユーザーについても、今回のAさんはロボットが鍵を開けたことに対して、「ありがとう、でもダメだよ」というような曖昧な指示をロボットにしていました。ユーザーもその人工知能の特性を理解し,使いこなしていく必要があるのだと思います。

国際的な人工知能のルールを作る動きはあるのでしょうか? そのときには宗教や文化の違いがあって,難しいのではないでしょうか?

(稲谷)自動車に関して、道路の規則や運転免許の基準は条約で決まっています。自動運転車がその条約に抵触しないために、どのような改正が必要かというルール作りがなされ始めています。また、人工知能の倫理規定については、大きな国際学会で議論がなされています。ただし、具体的な法制度をどのように構築するかについての検討はまだ国際的に進んでいないのが現状です。

(松浦)我々の世界は時代や地域によって違います。極端なことを言うと、自動運転車で事故に遭ったのは前世の行いが悪かったから、という文化圏もありえます。その文化圏では違ったルール作りになると思います。ですので、各文化に合わせてルールを調整することになるかもしれません。そこにもし国際標準を設けるということになると、その文化間の差異を乗り越える作業が必要になります。

人工知能の倫理的な判断をどのようにアルゴリズム化するのでしょうか?

(河合)どのような振る舞いが「良いこと」なのか、あるいは、期待されるのかは文化圏で違うことが想定されます。MITのモラルマシンプロジェクトでは、車内の人・車外の人、それが子どもなのか、お年寄りなのか、などの様々な状況に対して自動運転車がどのように判断すべきだと思われているのかが世界的に調査されています。また、ロボットに対する期待が文化圏で異なることを示すデータもされています。米国人は、人には道徳的な判断を期待する一方で、ロボットには合理的な判断を期待する傾向にあります。一方で、日本人はロボットにも人と同様に道徳的な判断を期待する傾向にあることが報告されています。しかし、あらゆる行為に一般的に適用可能な、振る舞いの「良さ」を定義することは難しく、おそらく皆さんもお持ちではないと思います。人の振る舞いの「良さ」の原理のようなものは哲学の分野で議論されているのでしょうか?

(松浦)哲学、特に倫理学領域では、何が良くて何が悪いのかはもちろん大問題なのですが、それと同様に、どのようにして人間たちは道徳的な判断をしているのかについての議論の蓄積があります。人工知能研究者がそのような議論をベースにして、道徳的な機械を作る素地はあると思うのですが、いかがでしょうか。やってみませんか? もしダメだったら、この議論は間違っていたんだということになりますし。

(河合)いわゆるモラルマシンやモラルエージェントを作る枠組みを探る取り組みはあるのですが、その哲学的な蓄積にどの程度基づいているのかはわかりません。様々な状況に対応したり、文化圏を超えたりすることを考えると、歴史の中で磨かれた価値観が必要になるのだと思います。哲学を踏まえた人工知能の設計は取り組むべきことだと思います。

(松浦)例えば、カントの道徳哲学に表れている人間像をそのままシミュレートするロボットどこまで人間が道徳的になれるのかを検証できますよね。たぶん失敗しますけど。ですが、それで、どこまで人工知能と我々人間が道徳的に振る舞えうるかはある程度わかるようになるのではないかと思います。どうですか? カントロイド!

(河合)そのときには、哲学の言葉で語られていたことをどのようにプログラムに落とし込むか、その間に大きな壁があるのだと思います。その付き合わせから始まりますね。

人工知能の事故に対する保険や基金があることで,レベルの低い製品が世に出回ることになりませんか?

(稲谷)素晴らしいご指摘です。これは法学では、経済学由来の言葉ですが、モラルハザードと呼ばれる典型的な問題です。保険に入ると、自分が責任取らなくていいかなという気持ちになり、実際、自動車保険に入ると運転が荒くなるというデータがあります。そこで、そのようなことが起きないように監視するメカニズムが必要になります。保険や基金は民事法の領域で、損害を受けた人を救済するシステムです。一方で、刑事法はその損害が起きないようにするシステムです。それらのような様々な法分野が協力することで、保険があるからといって安易におかしな行動をすると、刑事法で捕まったり、行政規制で免許取り消しになったりすることがあります。このように複数のシステムを組み合わせて、モラルハザードを防いで、かつ、技術開発を抑制しないように法を設計します。

謝辞

これらのイベントは、科学技術振興機構(JST) 社会技術研究開発センター(RISTEX)「人と情報のエコシステム (HITE)」領域の三つの研究開発プロジェクト

の合同企画です。

本イベントは日本科学未来館 市民参加型実験「オープンラボ」事業として実施され、映像制作からワークショップ開催に至るまで、片平圭貴氏と宮田龍氏をはじめとした日本科学未来館の多くの科学コミュニケーターとスタッフにご協力いただきました。2019年8月現在、このイベントを元に制作した15分程度の科学コミュニケーター・トークが日本科学未来館の常設展で実施されています(開催日時は不定期となっております。会場でご確認ください)。また、映像制作にあたり、有限会社デンバク ファノ デザイン 土井誠史氏に演出をしていただきました。

本イベントにご参加くださいまして、貴重なご意見をくださいました皆様に改めて御礼申し上げます。今後も同様のイベントや調査を計画しておりますので、皆様のご協力をお願いいたします。どうぞ皆様のお声をお聞かせください。

リンク

- 国立研究開発法人 科学技術振興機構 (JST)

- 日本科学未来館

- 特別鼎談「人工知能時代の責任と主体とは?」:松浦和也氏、葭田貴子氏、稲谷龍彦氏の三者による人工知能の責任に関する議論です。

- AI時代の「責任・主体」:「人と情報のエコシステム」研究開発領域の第1回シンポジウムでの松浦和也氏、葭田貴子氏、稲谷龍彦氏を含むパネルディスカッションの記事です。

- プロジェクト訪問「ロボットのための法律・哲学・心理相談所」開催:東京工業大学での高校生向けワークショップの記事です。

- JST news 2019年5月号「近く人間と人工知能の距離:互いに寄り添う新しい社会へ」:JST/RISTEX/HITE領域「自律性の検討に基づくなじみ社会における人工知能の法的電子人格」プロジェクトの特集記事です。日本科学未来館でのイベントについても言及されています。

- 東洋経済オンライン「自動車最前線」