本プロジェクトは、科学技術振興機構(JST)社会技術研究開発センター(RISTEX)の発信する公募型研究開発領域の一つである「人と情報のエコシステム」の研究プロジェクトです。 本プロジェクトでは、近年のAI技術は、人工システムやロボットにおけるある種の自律性を可能にし、ちょうど親離れした子供のように設計者が予測できない行動を表出する可能性があることを指摘します。このような状況では、現在の法制度では設計者か利用者が過度な法的責任を負わされる恐れがあり、健全な科学技術の進展を阻害する可能性があります。そこで、人工システムの自律性をその目的の有無やその書き換え可能性に準じて三段階程度を想定し、従来の法人格論の分析を通じて、これらの段階に応じた法的取扱モデルを考案します。さらに、既存の責任理論の問題点を指摘し、リーガルビーイングズ (Legal Beings) としての人工システムに対する新たな制度を提案します。また、アンドロイドを用いた模擬裁判を通じ、一般社会になじんだ法整備案を提案し、自律性の概念の深化と未来社会に通用する人工システムとその環境を提示します。

プロジェクトビジョン

これまでの法学と技術に関する研究は、いかに新しい技術が新しい危険を生み出しえるかを予想して、損害が発生した場合に関係者に責任を負わせたり、その開発を規制したりする方法に重点が置かれてきました。しかし、様々なレベルの自律性を有する最近の人工知能の登場はこのような従来の法学的手法の限界を示しています。例えば、人間と相互にルールを修正しながらコミュニケーションをするような高い自律性を有する人工知能は、利用者においてそれが搭載されたシステムの振る舞いを逐一コントロールするものではないため、従来の手法により関係者のみに責任を負わせる手法では、結局開発自体を規制せざるをえなくなってしまう可能性があるからです。 このような観点から近年法律学で問題とされているのは、「法人格」という、現在人間やその他の団体が享受している地位を、人工知能にも広げるべき場合があるのではないかといった点です。つまり、ロボットにも適用できる新しい法人格のカテゴリーを作ることの是非が議論されています。今求められているのは、各国における規制の手法等といった表面的考察ではなく、人間のみをそのメンバーと認め、責任主体とする伝統的な法的原理そのもののあり方についての基礎的考察と、人工知能のあり方についての積極的な考察です。 本プロジェクトでは、人間のみを想定する規範の主体論を修正できるか否かという問題を、その前提条件となる人工知能の自律システム設計という作業とインタラクティブな形で行うことによって、人工知能が責任を負ったり法的規範を適用したりできる主体 (リーガルビーイングズ:Legal Beings) に加われるか否か、できるとすればその条件は何かについて、基礎理論的に検討し、将来のなじみ社会における人工知能技術の実装に備えることを目指します。

なじみ社会における人工知能とは?

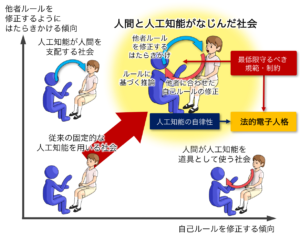

「なじみ社会」とは「人工知能と人間のなじみがとれた社会」のことです。なじみ社会は、「人工知能が人間を支配する社会」(1) や「人間が人工知能を道具としてのみ使う社会」(2) と対置することができます。(1) について、深層学習に代表される近年の人工知能の興隆により、ブルーカラーのみならず、弁護士や研究者などの高度の専門知識を必要とするホワイトカラーの職が奪われると警告されています(「ロボットの脅威」マーチン・フォード、2015)。人工知能への恐怖を煽る一般向けの本では、人工知能が無限に拡大することによって全知全能の人工知能が登場する世界が描かれることがよくあります。このような世界では、人工知能は人工知能間のみでコミュニケーションをとり、人間と人工知能のコミュニケーションは不要なものとされます。このような社会は(1) に属すると考えられます。これに対して (2) には、これまでの社会、あるいは (1) のシナリオを嫌う人々の反動によって理想とされる社会が属すると考えられます。 (1) や (2) の社会とも異なるのが、なじみ社会です。この社会においては、人工知能は人間とのコミュニケーションの中で自己のルールを修正するだけでなく、他者のルールを修正するようにはたらきかけます。このように人工知能と人間が相互作用的にルールを創成することによって、人工知能は必ずしも人間の手足とはならず、また、社会の中で人間を排除したり、支配したりすることもしません。しかし、そのような自律的な人工知能は、設計者の意図しない行動をすることが考えられ、そのための法整備が必要となります。

グループ構成

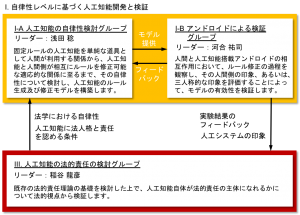

I. 自律性レベルに基づく人工知能開発と検証

I-A 人工知能の自律性検討(浅田稔・大阪大学)

このグループでは、人工知能の自律性に関して検討します。人工知能にはルールの修正可能性に応じて様々なレベルの自律性が存在します。システムが設計者の意図通りにしか機能しない固定的なレベルから、人間との関わりの中で新たなルールを獲得したり、人間側にルールの修正を教示したりするレベルまで考えられます。これらを包括的に扱うモデルを構築し、それぞれのレベルが法的観点で、人間社会にどのように受け入れられるのかを考察・検討します。

I-B ロボットによる実験と検証(河合祐司・大阪大学)

法人格付与の条件に関するプロジェクト全体での検討結果を踏まえ、最終的に、ルールに関する推論に基づいてルールを修正するモデルをロボットに実装し、実際の人間とのコミュニケーション実験を実施します。ロボットの自律性の各レベルに対して、対峙する人間が抱くロボットの印象や主観的な責任分配を調査します。

II. 人工知能の法的責任の検討(稲谷龍彦・京都大学)

まず、既存の法理論や倫理論の見地から、様々な分野において人工知能の開発者・設計者・所持者・占有者等の責任問題がどうなっているかについて整理します。その上で、基本的に人間のみしか認めていない既存の法理論や倫理論の哲学的前提について批判的分析を行います。そして、既存理論の哲学的前提の検証作業を踏まえて、「事物の道徳性」論の観点からそれに修正を加えることにより、人工知能が実装されたシステムをなじみ社会における信頼できる一個の道徳的主体として迎え入れるための、倫理的・法的責任論を検討します。また、法的責任の検討にあたっては、人工知能に対する、法的人格を付与することの是非及び、条件についても検討します。

(法人格が認められる条件についての法学的検討グループ(グループリーダー:西貝小名都)は2018年8月末をもって解散いたしました。旧グループ構成につきましてはこちらをご覧ください。)